Volete sapere come fare per impedire ai crawler di Google, ma anche altri motori di ricerca, di accedere a determinati file, cartelle e pagine web? L’appuntamento settimanale di Google Webmaster “Lo sapevate che..”, spiega proprio come poterlo fare.

Volete sapere come fare per impedire ai crawler di Google, ma anche altri motori di ricerca, di accedere a determinati file, cartelle e pagine web? L’appuntamento settimanale di Google Webmaster “Lo sapevate che..”, spiega proprio come poterlo fare.

Cosi come descritto sul forum, per inibire l’accesso a determinate pagine presenti nel vostro sito, è necessario creare un file robot.txt dove inserire i percorsi di tutti i file e cartelle da limitare.

In genere pagine contenenti informazioni riservate, o credenziali di accesso, non debbono essere indicizzate da Google, quindi dovremo dire al crawler di saltare l’indicizzazione. Per creare un file robot.txt possiamo usare un semplice editor di testo, e una volta inseriti i percorsi, questo file dovrà essere caricato nella cartella principale del nostro sito.

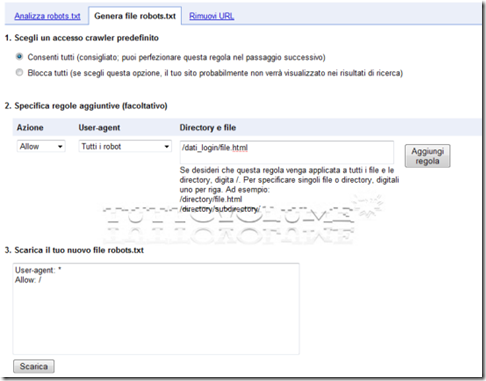

Per semplificare la creazione del file robot.txt, negli Strumenti per webmaster di Google, sezione Configurazione sito/ Accesso crawler, troverete un tool che permette di generare e analizzare il file robot per il tuo sito web, indicando azione, directory e User-agent da limitare.

Al termine sarà possibile generare il file robot.txt contenente le impostazioni, e le cartelle de non indicizzare.

Il prossimo appuntamento di Lo sapevate che…, sarà molto interessante, perché conterrà informazioni su come trasferire un sito web. (via)